Google Brainらは、画像を予測する報酬(Reward)のみを予測するモデルに比べて、精度パフォーマンスを大幅に向上させることができることを実証。公開されたオープンソースの(世界モデル)とコラボレイトリー(colab)で、この作業を再現し、世界モデルのライブラリを使用するか、拡張することができる。

「モデルのない強化学習(Model-free Reinforcement Learning)」は、ロボット工学、制御、ゲーム、自律走行車を含む様々な分野でその能力を発揮している。これらのシステムは、単純な試行錯誤によって学習するので、与えられた課題を解決する前に、膨大な数の挑戦が必要である。

逆に「モデルベース強化学習(Model-based Reinforcement Learning。以下、MBRL)」は、エージェントが潜在的な作業の結果を予測できるようにする環境モデル(世界モデルまたは力学モデルとも呼ばれる)を学習してタスクを解決するために必要な相互作用の量を大幅に減少させる。

原則として(In principle)計画に不可欠なのは、将来の報酬(Reward)を予測するものであり、これは最適の将来の行動を選択するために使用することができる。それにもかかわらず、Dreamer、PlaNetとSimPLeなど、最近の方法は、将来のイメージを予測する学習信号を追加で活用する。

しかし、将来のイメージを予測することが実際に必要なのか、それとも助けになるか ビジュアルMBRLアルゴリズムは、将来のイメージ予測でも、実際にどのようなメリットを得るか 全体のイメージを予測するためにかかる計算とコストが相当するので、これが実際に有用なのかを理解することはMBRLの研究に非常に重要である。

昨年12月8日に発表されたGoogleブレイン研究チームの論文「モデル、ピクセルと補償:ビジュアルモデルベース強化学習の設計トレードオフの評価(Models、Pixels、and Rewards:Evaluating Design Trade-offs in Visual Model-Based Reinforcement Learning)」では、将来のイメージを予測することが重要な利点を提供し、実際に成功したビジュアルMBRLエージェントを教育するために重要な要素であることを示している。

グーグルブレインとスイスAI研究所の共同研究チームが2018年に発表した論文(Recurrent World Models Facilitate Policy Evolution)を介して、世界モデル(World Models)と呼ばれる新しいオープンソースのライブラリを発表したが、これにより、GoogleのAI研究チームは、画像予測がそれぞれのリターン補償に及ぼす相対的な影響を決定するために、様々な世界のモデル設計を厳密に評価することができた。

また、ビジュアルMBRL訓練および評価のために特別に設計された、世界モデルライブラリは、各設計上の決定が大規模に複数のタスクにわたってエージェントの最終性能に及ぼす影響についての実証研究を可能にする。

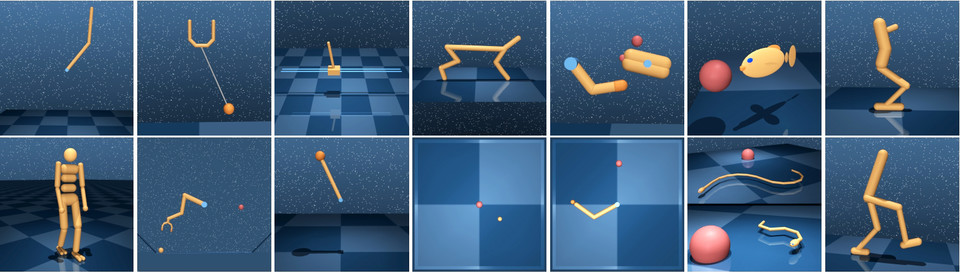

このライブラリは、プラットフォームに依存しないビジュアルMBRLシミュレーションループとAPIを導入して、新しい世界のモデル、立案者、および作業を円滑に定義するか、エージェント(例えば、PlaNet)、ビデオモデル(例えば、SV2P /論文「確率的変異ビデオ予測」)と、CEM(クロスエントロピー方法)とMPPI(論文)のような様々なディープマインドコントロール(DeepMind Control Suite)の作業と計画者を含む既存のカタログから選択する。

ライブラリを使用して、開発者は、モデルの設計や表現空間のようなMBRLの様々な要素が、一連の作業のために、エージェントのパフォーマンスに与える影響を研究することができる。ライブラリは、特定のタスクに対して事前訓練されたエージェントの評価だけでなく、最初からまたは事前収集した軌跡セットでエージェント訓練を支援する。モデルは、計画アルゴリズムおよびタスクを簡単に混合し、目的の組み合わせに合わせることができる。

ユーザーに最大限の柔軟性を提供するために、ライブラリは、NumPyインタフェースを使用して構築されており、このインタフェースを介してテンソルフロー、パイトーチまたはJAXのさまざまなコンポーネントを実装することができる。簡単な紹介のためにコレボレイトリー(Colab)を参照すればよい。

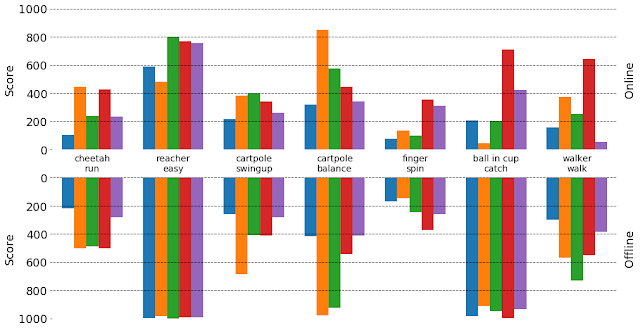

また、世界のモデルライブラリを使用して、異なるレベルの画像予測のいくつかの世界のモデルを学習した。これらのすべてのモデルは、同じ入力(以前に観察された画像)を使用して画像と補償を予測するが、画像の何パーセントを予測するかによって違いがある。エージェントから予測された画像のピクセル数が増加すると、一般的に、実際の報酬(Reward)として測定されるエージェントのパフォーマンスは向上する。

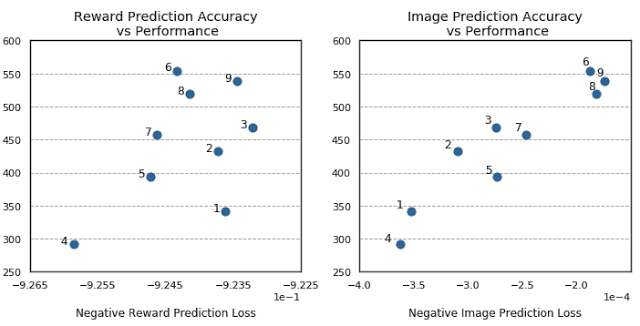

興味深いことに、報酬(Reward)予測の精度とエージェントのパフォーマンスの間の相関はそれほど強くなく、場合によっては、より正確な報酬(Reward)予測によってエージェントのパフォーマンスが低下することさえあります。同時に、画像再構成エラーとエージェントのパフォーマンスの間には強い相関関係があります。

この現象は、探索に直接関係しています。つまり、エージェントが環境内の未知のオプションに関するより多くの情報を収集するために、よりリスクが高く、報酬が少ない可能性のあるアクションを試みる場合です。これは、オフライン設定でモデルをテストおよび比較することで示すことができます(つまり、環境と対話してポリシーを学習するオンラインRLとは対照的に、事前に収集されたデータセットからポリシーを学習します)。オフライン設定により、探索が行われず、すべてのモデルが同じデータでトレーニングされます。通常、データに適したモデルはオフラインセットアップでパフォーマンスが向上することがわかりました。驚くべきことに、これらは、ゼロから学習して探索するときに最高のパフォーマンスを発揮するモデルとは異なる場合があります。

画像を予測すると、期待される報酬(Reward)のみを予測するモデルよりもタスクのパフォーマンスが大幅に向上することを経験的に示しました。

また、画像予測の精度は、これらのモデルの最終的なタスクのパフォーマンスと強く相関することも示しました。これらの調査結果は、より良いモデル設計に使用でき、入力スペースが高次元でデータの収集に費用がかかる将来の設定に特に役立ちます。

独自のモデルを開発したい場合は、リポジトリとコラボにアクセスして、この作業を再現し、ワールドモデルライブラリを使用または拡張してみてください。

Evaluating Design Trade-offs in Visual Model-Based Reinforcement Learning